Gemini api使用

gemini-2.0官网说明:https://developers.googleblog.com/en/gemini-2-family-expands/

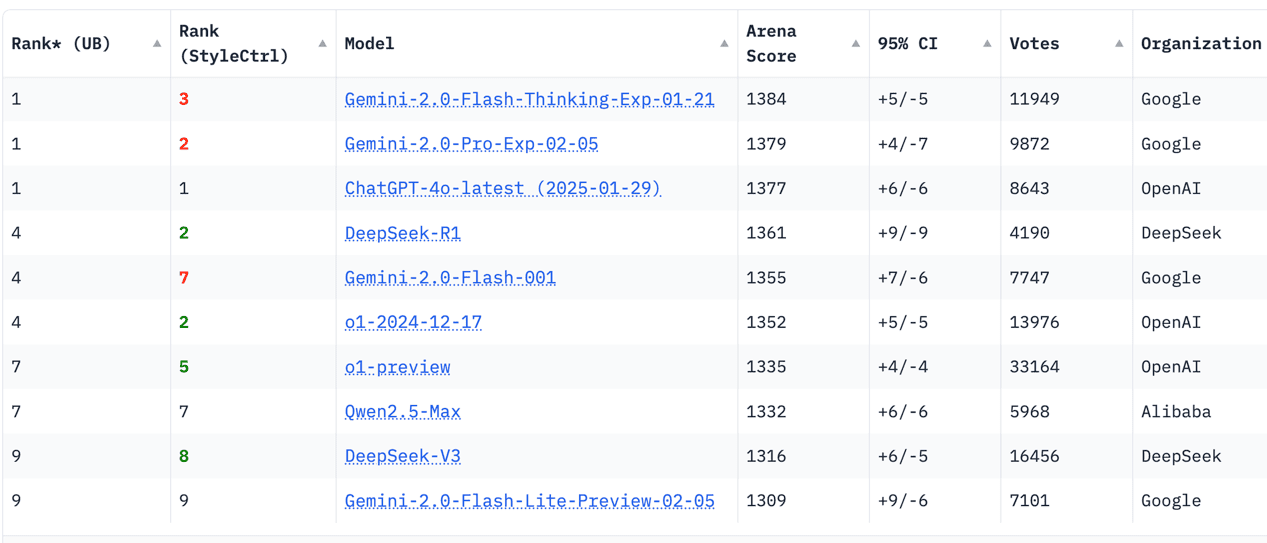

截止2025.2.16,评测榜leaderboard排行:

可以看到最近发布gemini2.0家族强势霸榜,实际体验也非常惊艳,不仅非常快,也非常智能,同时还支持多模态;更关键的是不仅网页全部免费使用,api的免费额度也非常慷慨,个人日常和研究使用是基本用不完了。

api获取与使用

获取 Gemini API 密钥教程:

获取api的官网网址:

获取完api后,建议是写入当前用户的shell环境变量,zsh下是:

bash

vim ~/.zshrc

export GEMINI_API_KEY=<YOUR_API_KEY_HERE>

source ~/.zshrc测试api是否能用:

bash

curl --socks5-hostname localhost:2080 "https://generativelanguage.googleapis.com/v1beta/models/gemini-2.0-flash:generateContent?key=$GEMINI_API_KEY" \

-H 'Content-Type: application/json' \

-X POST \

-d '{

"contents": [{

"parts":[{"text": "你好,介绍一下你自己"}]

}]

}'注意:

--socks5-hostname localhost:2080是代理- 接口模型使用的是

gemini-2.0-flash

查询所有公开的模型列表:

bash

curl --socks5-hostname localhost:2080 "https://generativelanguage.googleapis.com/v1beta/models?key=$GEMINI_API_KEY"查询结果有点多,关注某一个模型比如gemini-2.0:

bash

curl --socks5-hostname localhost:2080 "https://generativelanguage.googleapis.com/v1beta/models?key=$GEMINI_API_KEY" | grep gemini-2.0就可以得到目前公开的api清单:

json

"name": "models/gemini-2.0-flash-exp",

"name": "models/gemini-2.0-flash",

"name": "models/gemini-2.0-flash-001",

"name": "models/gemini-2.0-flash-lite-preview",

"name": "models/gemini-2.0-flash-lite-preview-02-05",

"name": "models/gemini-2.0-pro-exp",

"name": "models/gemini-2.0-pro-exp-02-05",

"name": "models/gemini-2.0-flash-thinking-exp-01-21",

"name": "models/gemini-2.0-flash-thinking-exp",

"name": "models/gemini-2.0-flash-thinking-exp-1219",模型名称解释:

- flash 定位快

- pro 定位强

- lite是更轻量版,thinking是推理、思考更强

- exp是代表实验性质,可能不稳定,使用的技术是最新的

- 带日期的比不带日期的一般更新,日期越近越新

综上,个人api使用的话,使用gemini-2.0-flash-thinking-exp和gemini-2.0-pro-exp一般就够用了。

官网关于api调用价格的说明:https://ai.google.dev/gemini-api/docs/pricing?hl=zh-cn

Gemini API 使用入门:

api方式使用的局限

结果肯定是不如直接网页/app使用的,比如:

api就不支持google联网和youtube、map搜索等。官网网页/app使用体验会更好。

关于google AI studio

aistudio官网:

什么是google AI studio

Google AI Studio 是一个由 Google 提供的免费在线开发平台,旨在让开发者能够快速原型设计和构建生成式 AI 应用,特别是使用 Google 最新的 Gemini 模型。

对于个人用户来说,Google AI Studio 可以用来做很多事情,主要集中在探索、学习和实验生成式 AI 技术上